Adolf Würth GmbH & Co. KG

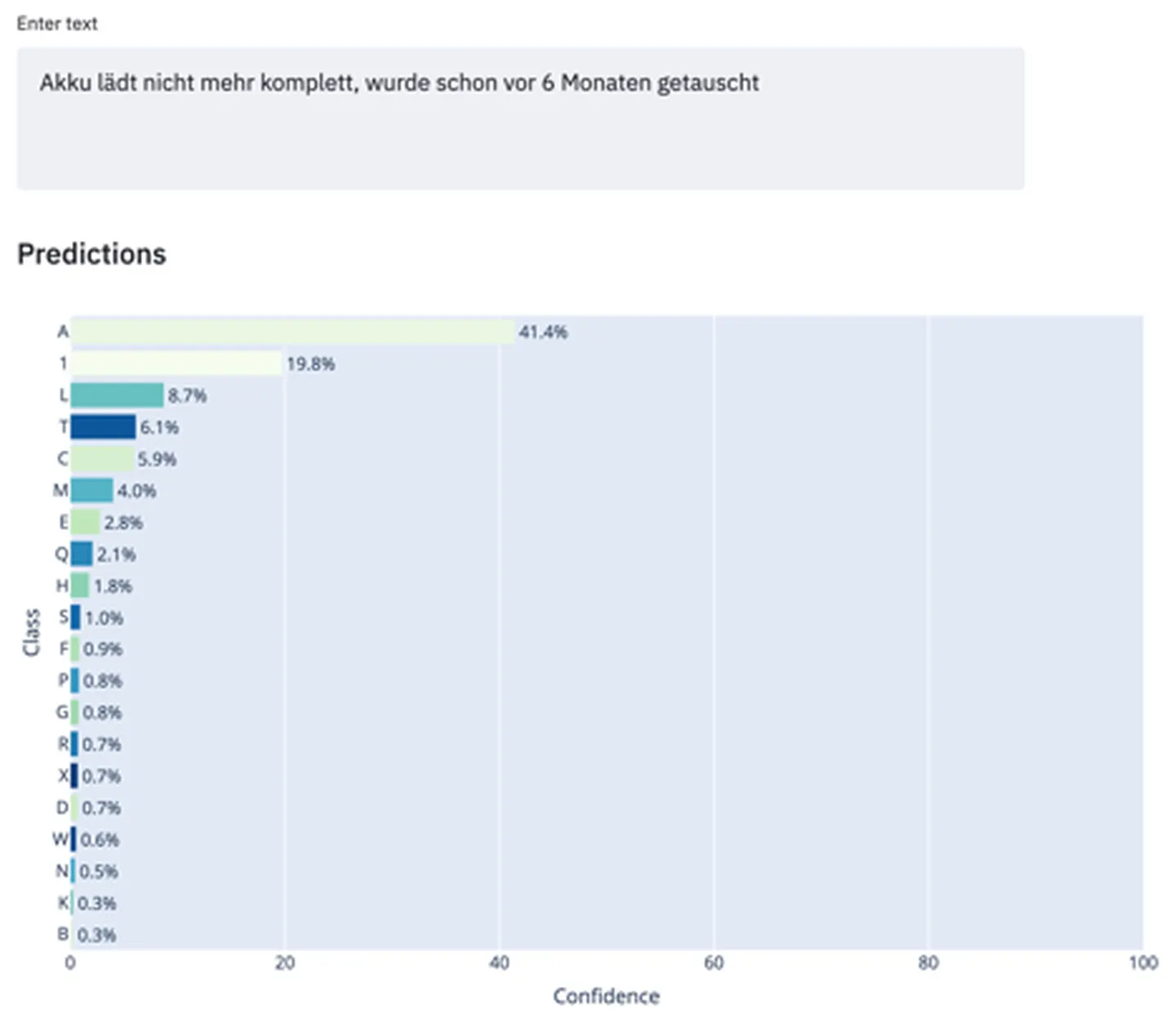

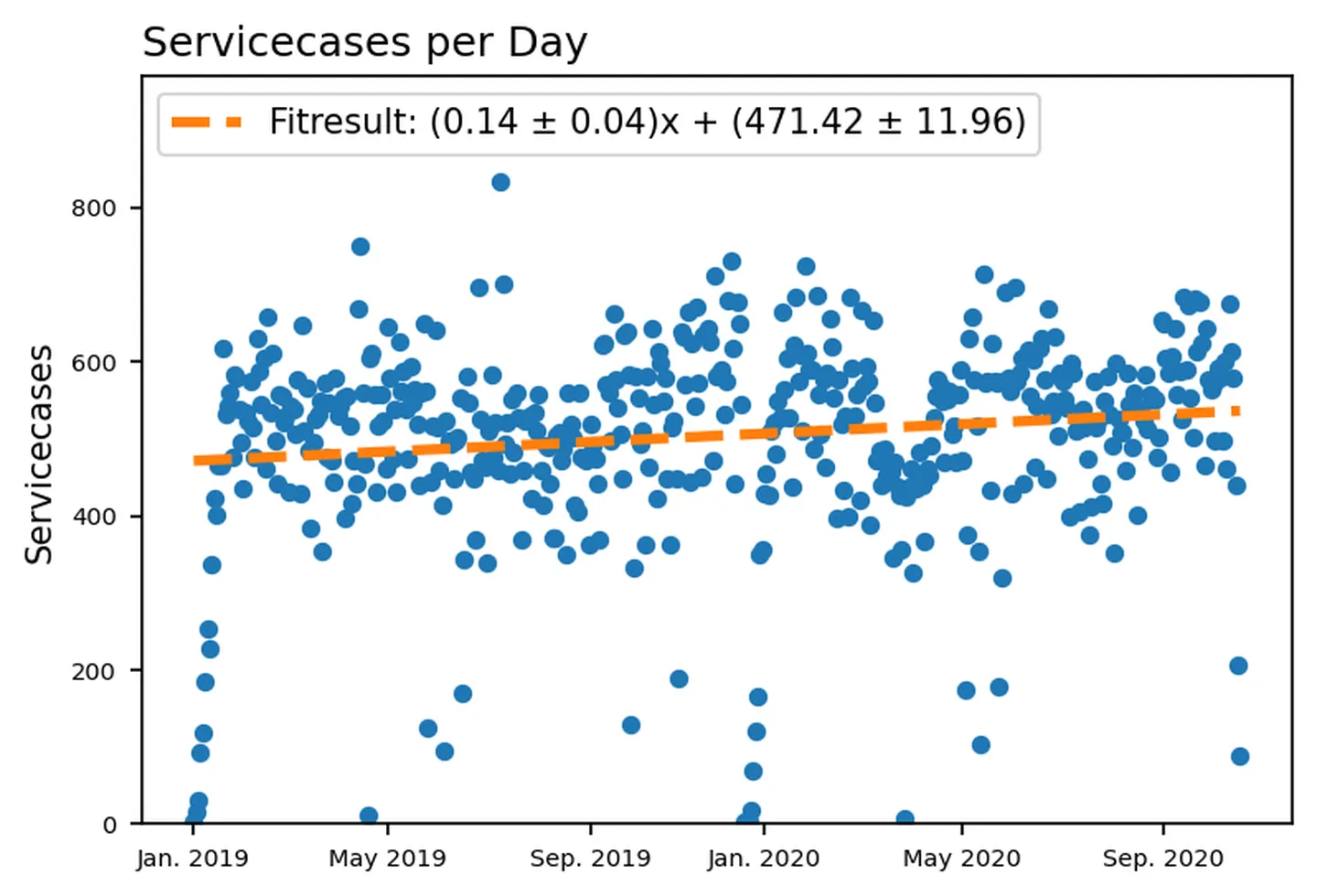

Würth ist Spezialist für Montage- und Befestigungsmaterial und schaut mittlerweile auf eine 75-jährige Betriebsgeschichte zurück. Mit über 400 Gesellschaften ist das weltmarktführende B2B-Unternehmen in 80 Ländern vertreten. Würth bietet zu seinen Produkten auch Planer, Konfiguratoren, Seminare und weitere Services an, wie z. B. den Würth MASTERSERVICE. Würth wartet, kalibriert und repariert im Rahmen seines MASTERSERVICES täglich ca. 500 Geräte. In diesem Kontext sind die anfallenden Daten zu den einzelnen Servicefällen nicht nur interessant, sondern essenziell, um den Service weiter optimieren zu können.